潮人地東莞seo博客小編下面跟大家分享關于百度seo優化排名:通過robots.txt文件屏蔽蜘蛛抓取不存在的后綴等問題,希望seo專員在做seo優化的過程中有所幫助,內容僅供參考。

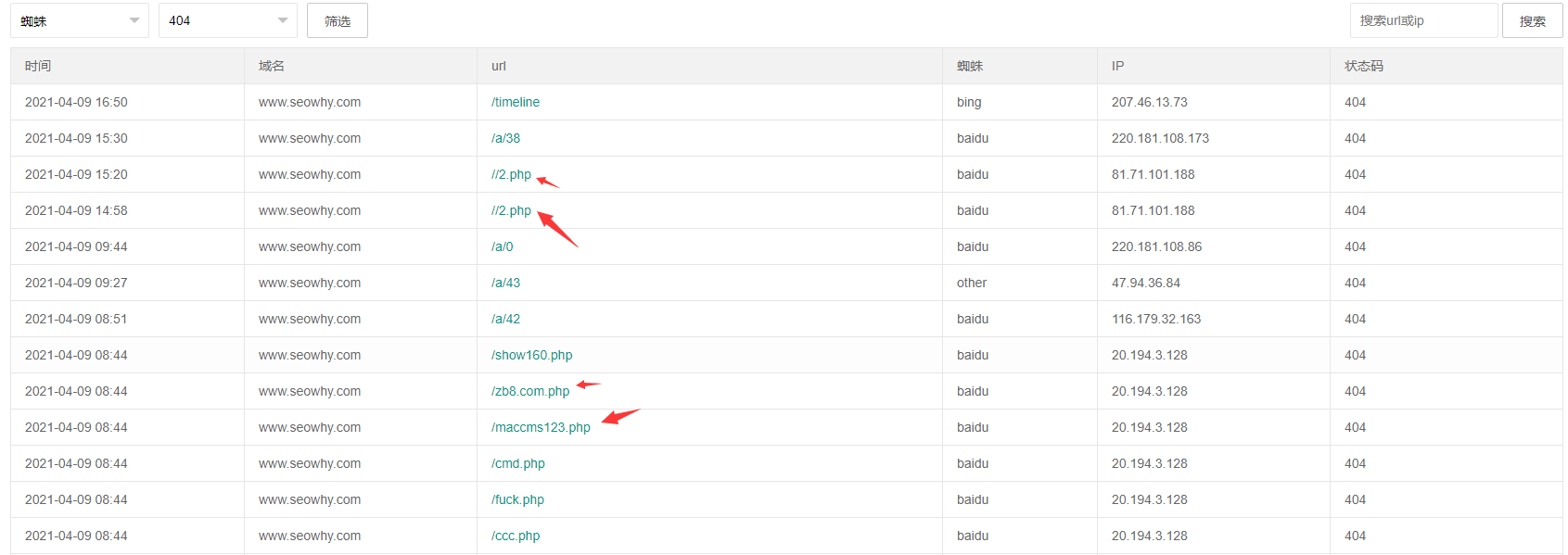

通過網站日志分析,會發seo推廣優化有哪些方法現搜索引擎蜘蛛抓取了一些網灰帽seo的優化方法站上不存在的文件后綴,如:.php、.asp、.aspx等。

搜外網站后臺日志分析結果如下圖:

seo博客相關推薦閱讀:seo博客技術分享:rel=alternate是怎樣標簽,有怎樣用

搜外主站實際上不存在php后綴的URL地址。

可通過robots.txt文件禁止蜘蛛抓取不存在的后綴,減少出現404返回值。

?

在robots.txt文件填寫屏蔽規則如下:

Disallow:?/*.asp$Disallow:?/*.php$Disallow:?/*.aspx$

注意前面一個*,后面一個$,代表后綴。

參考搜外的robots.txt文件寫法,點擊這里

擴展seo100個優化方法閱讀:

robots.txt概念和10條注意事項

?

以上是潮人地東莞seo博客跟大家分享關于百度seo優化排名:通過robots.txt文件屏蔽蜘蛛抓取不存在的后綴等問題,希望能對大家有所幫助,若有不足之處,請諒解,我們大家可以一起討論關于網站seo優化排名的技巧,一起學習,以上內容僅供參考。