潮人地東莞seo博客小編下面跟大家分享關于「seo搜索引擎優化如何做」使用.htaccess調整或阻止網站機器人和蜘蛛等問題,希望seo專員在做seo優化的過程中有所幫助,內容僅供參考。

截至2012年,僵尸網絡流量超過了網絡上的人流量,平三水seo搜索引擎優化怎么做均而言,您網站上超過50%的點擊量來自機器人而非人類。

機器人具有廣泛的用途,并非所有這些都是壞的。有些機器人,比如Google和百度使用的機器人,會對您的網頁進行抓取和索引。

如果您要阻止Googlebot或百度蜘蛛,您的網站最終將從其索引中刪除;?他們無法再訪問它,因此您的內容不會顯示。

seo博客相關推薦閱讀:seo優化推廣:懂技術的seo(懂技術的管理者)

有些機器人僅用于抓取電子商務網站,尋找交易。他們交叉引用他們可以找到的每個電子商店與給定的產品,因此家庭網站可以顯示在各種商店的產品價格。

一些網站將使用這些來確保它們位于列表的首位,競爭賣家通過調整價格來互相推銷。

一些垃圾郵件機器人將搜索博客,尋找并利用各種評論系統。沒有身份驗證或驗證碼的評論可以由機器人填寫,垃圾評論可以留給垃圾網站建立鏈接,捕獲無知的網絡用戶的點擊,甚至炸毀負面搜索引擎優化的其他良性網站。

一些黑客機器人抓取網站以查看網站基礎設施。他們測試域以查找常見的/admin.htm樣式URL,查找使用默認CMS且未更改用戶名或密碼等內容的網站。他們搜索易受攻擊的網站,他們可能會收集管理員或用戶信息,或只是將URL報告給黑客機器人的所有者。它們可能被編程為簡單地刪除一個站點并用它們自己的內容替換它。

惡意機器人源于計算機病毒。他們接管用戶的計算機,無論是公開還是在后臺,都使用該計算機的互聯網訪問功能來執行病毒所有者想要做的任何事情。通常,這只是用于在DDoS攻擊中錘擊給定的URL,旨在取消網站,或者強調服務器足以讓黑客通過代碼中的錯誤進入。

采集機器人也是惡意的;?他們就像搜索引擎機器人一樣,抓內容。但是,它們不是將其添加到搜索索引中,而是簡單地復制內容批發。內容,腳本,媒體;?它全部下載并放置在垃圾郵件發送者的服務器上,因此他們可以收集這些數據 – 或者只是粘貼群發 – 其垃圾郵件站點的內容。這對他們來說都是一次性的,只是他們收獲的資源,當它不再有用時就會丟棄。

顯然,這些機器人有很多問題。然而,除了他們的目的,他們還有另一個副作用;?服務器壓力。機器人能夠以簡化的輕量級方式訪問您的網站 – 搜索引擎機器人經常這樣做 – 但即使他們這樣做,他們仍然訪問您的網站。他們仍然下載內容,從您的服務器發出請求,并且通常會耗盡資源。

在許多情況下,這甚至可以打倒一個網站。

如何阻止機器人?

有兩種方法可以阻止機器人試圖訪問您的網站。一個是通過robots.txt文件,另一個是通過.htaccess文件。

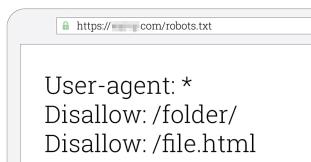

什么是robots.txt文件?

robots.txt文件是放在服務器根目錄中的文本文件。其目的是為想要訪問您網站的機器人提供指導。您可以使用它來阻止對特定機器人或所有機器人的訪問。

為什么不使用robots.txt?

robots.txt的問題在于它為機器人提供了指導。如果機器人選擇不尊重它 – 我的意思是,如果機器人的創建者將其編程為忽略robots.txt – 你就無法做任何事情。這就像打開你的大門一樣,但張貼的標語上寫著“劫匪遠離。”如果強盜選擇忽略標志,沒有什么能阻止他們走過大門。

.htaccess文件是Apache Web服務器軟件使用的配置文件。它更像是前門的保安,積極阻止潛在的劫匪。除非在這種情況下,保安人員有能力看到試圖進入的人是否來自RobberHome,穿著一件上面寫著“我是強盜”的襯衫,或以其他方式表明身份。

這意味著.htaccess文件可以主動阻止大多數機器人,但不是所有僵尸程序。特別是,僵尸網絡機器人 – 來自普通用戶的從屬計算機 – 通常不會被默認阻止。這是因為那些是常規用戶計算機,使用常規用戶軟件。如果你阻止他們,你就會阻擋人類。但是對于大多數其他機器人來說,.htaccess文件是理想的。

請注意,只有在Web服務器運行Apache時才能使用.htaccess文件。如果您正在使用Nginx,Lighttpd或其他一些小眾服務器架構,那么您必須找到該軟件阻止機器人的方式。

識別要阻止的機器人

首先,一句警告。通過.htaccess文件阻止機器人時要非常小心。一個錯字,你最終可以阻止整個互聯網。顯然你不想那樣。

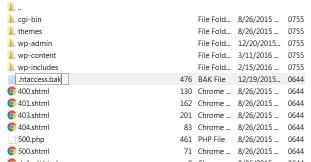

您要做的第一件事是備份當前的.htaccess文件。如果出現阻止您不想阻止的流量的錯誤,您可以恢復舊文件以還原更改,直到您可以找出問題所在。

您要做的第二件事是弄清楚如何找到自己的訪問日志。使用Apache,您需要使用Linux / Unix命令來訪問日志文件。

日志文件其中顯示了服務器訪問的詳細信息。它將顯示用于訪問服務器的IP地址,客戶端計算機的標識(如果可用),機器的用戶ID(如果使用身份驗證),請求的時間,是否由HTTP訪問,狀態代碼為服務器返回,以及請求的對象的大小。

日志文件將包含所有常規用戶的數據以及所有機器人訪問權限。一些機器人,如Google機器人,將通過其用戶代理信息識別自己。壞機器人有時會識別自己,但通常只有某些特征將它們標記為非人類。他們可能正在使用通常已被利用的瀏覽器的過時版本。它們可能來自已知的垃圾郵件地址或域。

通常,如果機器人每月只訪問您的網站一次,您不一定需要擔心它。如果你愿意,你可以阻止它,但它不一定能節省你的時間或精力。您的主要目標應該是阻止持續訪問的機器人,并對服務器的性能產生負面影響。

在按IP地址或IP范圍阻止時要非常小心。很容易看到很多機器人來自168. *.*.*,星星中有各種不同的數字,并認為“我可以阻止所有這些!阻止整個/ 8范圍!“問題是,IPv4中的?a?/ 8范圍是16,777,216個不同的IP地址,其中許多可能被合法用戶使用。您可以使用一個過于寬泛的規則阻止大量合法流量。

.htaccess文件中的大多數條目不會通過IP地址阻止,只是因為IP地址太容易通過代理進行更改。大多數將使用用戶代理名稱,來自無需更改的機器人的特定重復IP地址,或通常用于托管spambots或黑客工具的域。

使用.htaccess文件

我們將通過.htaccess文件使用三種方法來阻止僵尸程序。第一種是最常見的,使用機器人的用戶代理來阻止它。這通常是可靠的,因為普通用戶不會擁有機器人用戶代理。

在.htaccess文件中,首先需要一行“RewriteEngine on”。這一行確保任何后續的重寫行都可以工作,而不是被解析為注釋。

接下來,您可以添加“RewriteCond%{HTTP_USER_AGENT} \”作為自己的行。這使得基于用戶代理的重寫條件成為可能。你有兩個選擇;?您可以在這一行之后添加大量不同的用戶代理,也可以添加一個用戶代理,然后再次添加該行。例如:

RewriteCond%{HTTP_USER_AGENT} \12soso | \192 \ .comagent | \1noonbot | \1on婁煩seo優化方法1searchbot | \3de \ _search2 | \ [NC,OR]

要么:

RewriteCond%{HTTP_USER_AGENT} ^ [Ww] eb [Bb] andit [NC,OR]RewriteCond%{HTTP_USER_AGENT} ^ $ [NC,OR]RewriteCond%{HTTP_USER_AGENT} ^ Acunetix [NC,OR]RewriteCond%{HTTP_USER_AGENT} ^ binlar [NC,OR]RewriteCond%{HTTP_USER_AGENT} ^ BlackWidow [NC,OR]

兩者都很好。在第一個示例中,您需要每500個左右的條目添加一個額外的RewriteCond行。這是因為使用一個命令的行越長,Apache就越難解析。將其分解為單個條目會使其更加混亂,但可能更容易閱讀。無論如何,您可以使用任何一種方法。

最后的NC和OR位是重寫標志。NC表示“nocase”,表示該條目不區分大小寫。這意味著“12soso”和“12Soso”的處理方式相同。OR表示“this或that”,因為只要它與列表中的一個或另一個條目匹配,就會阻止機器人,而不是“簡述seo優化方法AND”,這將是所有這些條目。

在這里的機器人列表之后,您需要指定重寫規則。所有這些只是兩部分子句的第一部分:如果URL與此匹配,則……第二部分是發生的事情。在自己的行上添加“RewriteRule.* – [F,L]”。

這樣做是將來自bot用戶代理的任何傳入流量重定向到阻止的頁面。具體來說,它發送403 Forbidden代碼。[F]是Forbidden,[L]是一個代碼,表示應該立即應用重寫規則,而不是在解析.htaccess文件的其余部分之后。

另外兩種方法是基于HTTP引用的阻塞,以及基于IP地址的阻塞。

要通過HTTP引用來阻止,使用“RewriteCond%{HTTP_REFERRER}”作為起始行,使用剝離性引用者的域,如www1.free-social-buttons \ .com,并使用[NC,OR]塊。之后添加相同的RewriteRule行。你最終會得到這樣的東西:

RewriteCond%{HTTP_REFERER} www4.free-social-buttons \ .comRewriteRule ^.* ?-? [F,L]

最后,您可以簡單地基于IP地址進行阻止。如果您發現一個特定的IP地址特別有害,每小時向您的網站發送一百次或其他任何內容,您可以阻止它。只需寫下“Deny from *.*.*.*”,其中星號是IP地址。它看起來像“從173.192.34.95拒絕”,最后可能用/ 28或者其他東西阻擋一個范圍。

快捷鍵

如果所有這些都有點過于復雜,您可以使用快捷方式并使用其他人放在一起的列表。我找到了兩個推薦。首先是來自HackRepair.com的這個pastebin條目。第二個是Tab Studio中的列表。

每次使用.htaccess文件添加塊時,請務必先使用幾種不同的方法測試對站點的訪問。如果你以一種你不應該被阻止的方式被阻止,那么就會出現問題,你需要修復這個條目。

以上是潮人地東莞seo博客跟大家分享關于「seo搜索引擎優化如何做」使用.htaccess調整或阻止網站機器人和蜘蛛等問題,希望能對大家有所幫助,若有不足之處,請諒解,我們大家可以一起討論關于網站seo優化排名的技巧,一起學習,以上內容僅供參考。