潮人地東莞seo博客小編下面跟大家分享關(guān)于seo技術(shù)博客分享:你真的完全懂了robots嗎?等問(wèn)題,希望seo專員在做seo優(yōu)化的過(guò)程中有所幫助,內(nèi)容僅供參考。

文章出自光年論壇pollux(劉總)整理的【搜索引擎不會(huì)告訴你的關(guān)于robots的潛規(guī)則】,正好最近在碰到了robots的問(wèn)題,覺(jué)得文章非常有價(jià)值就轉(zhuǎn)載給大家。

seo博客相關(guān)推薦閱讀:seo網(wǎng)站心得之百度搜索將嚴(yán)格控制搜索中的權(quán)限問(wèn)題

meta標(biāo)簽中的robots在所有meta標(biāo)簽中,專門有一類是指導(dǎo)機(jī)器人如何處理抓取后的頁(yè)面,如何追蹤頁(yè)面上的鏈接的。描述這種信息的meta標(biāo)簽被稱為robotsmeta標(biāo)簽(robots meta tag),它就是本文的主角。

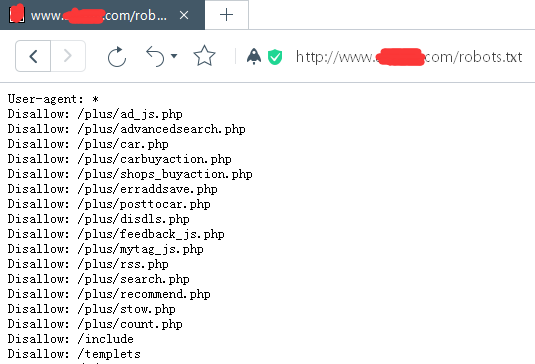

Robots文件是我們與搜索引擎對(duì)話的最重要渠道。

為什么meta信息有這么多種類,我們卻從來(lái)沒(méi)有在網(wǎng)頁(yè)上看到過(guò)它們呢?因?yàn)閙eta標(biāo)簽的內(nèi)容在瀏覽器上是不顯示的。絕大部分的meta信息是寫給搜索引擎看的,用于幫助搜索引擎判斷頁(yè)面的價(jià)值、重要性。

作為網(wǎng)頁(yè)設(shè)計(jì)者和搜索引擎交流的一個(gè)重要渠道,各種meta標(biāo)簽提供了從不同角度描述頁(yè)面的基礎(chǔ)信息,而機(jī)器人在訪問(wèn)網(wǎng)頁(yè)時(shí)也會(huì)首先讀取這個(gè)部分。

關(guān)于robots基礎(chǔ)閱讀:

http://www.baidu.com/search/robots.html

http://www.robotstxt.org/robotstxt.html

http://www.google.com/support/webmasters/bin/answer.py?Hl=cn&answer=156449

絕大部分 spider 能夠識(shí)別的是以下幾種:

- noindex -【頁(yè)seo團(tuán)隊(duì)技術(shù)面會(huì)被抓取,但在被google的后臺(tái)系統(tǒng)分析完以后會(huì)被丟棄,不會(huì)進(jìn)入google的索引排序,對(duì)用戶而言也就不會(huì)出現(xiàn)在搜索結(jié)果中】

- nofollow -【禁止googlebot追蹤頁(yè)面上的一切鏈接(阻止訪問(wèn))。(與meta級(jí)別的nofollow不同的是, link級(jí)別里的nofollow只會(huì)阻止robot追蹤單條鏈接)】

- noarchive -【禁止在搜索結(jié)果中顯示該頁(yè)面的快照】

- nosnippet -【禁止在搜索結(jié)果的網(wǎng)頁(yè)鏈接下顯示內(nèi)容摘要,同時(shí)阻止搜索引擎產(chǎn)生該頁(yè)面的快照】

- noodp -【在搜索結(jié)果的頁(yè)面摘要部分屏蔽open directory project對(duì)該頁(yè)面的描述】

- none -【等同于同時(shí)使用noindex和nofollow兩個(gè)參數(shù)】

robots文件的使用,有很多特別需要注意的,甚至很多知識(shí)點(diǎn)甚至搜索引擎本身都沒(méi)有給出詳盡的說(shuō)明或者是使用方法。在參閱了大量的資料和結(jié)合自身的一些嘗試,本文將重點(diǎn)說(shuō)明下,一些在對(duì)robots文件進(jìn)行處理的過(guò)程中需要特別注意的潛規(guī)則。

robots文件潛規(guī)則

不允許出現(xiàn)多條user-agent的記錄一份“/robots.txt”文檔中不允許出現(xiàn)多條包含“user-agent: *”的記錄(但允許沒(méi)有此記錄)。

spider名字的大小寫問(wèn)題大多數(shù)搜索引擎的spider在讀取user-agent值的時(shí)候都是忽略大小寫,既Googlebot和googlebot應(yīng)該都能被google識(shí)別。但是,我在學(xué)習(xí)淘寶seo的時(shí)候也發(fā)現(xiàn),或許為了保險(xiǎn)起見(jiàn),淘寶的工作人員在自己的“/robots.txt”里面分別寫了“user-agent: baiduspider”和“user-agent: baiduspider”兩條。(參見(jiàn):http://www.taobao.com/robots.txt)

allow和disallow的順序大部分情況下,想要兼容所有的機(jī)器人,就應(yīng)當(dāng)將allow指令放在disallow指令的前面,例如:

Allow: /a/b.html

Disallow: /a/

這會(huì)阻止對(duì)”/a/”內(nèi)除了”/a/b.html”以外一切內(nèi)容的檢索,因?yàn)楹笳呤莾?yōu)先匹配成功的。雖然對(duì)于google和百度來(lái)說(shuō),先后順序并不重要。但是不排除會(huì)導(dǎo)致其他搜索引擎出現(xiàn)抓取問(wèn)題。

allow與disallow的角力如果allow指令中的地址同disallow指令中的地址相比具有相同或更多字符(意味著allow指令所描述的地址更“深”、更“具體”)的話,雖然disallow指令也能匹配,但allow指令仍然會(huì)“獲勝”(這樣就達(dá)到開放子文件夾的目的了,同時(shí)沒(méi)被allow的部分依然不會(huì)被檢索)。

舉個(gè)例子吧(假設(shè)和順序無(wú)關(guān))

Disallow:/a/b

Allow:/a

這樣就是允許除b以外的所有a

Disallow:/a

Allow:/a/b

這樣就是禁止除b以外的所有a

反斜杠“/”的意義反斜杠“/”表示禁止搜索引擎進(jìn)入該目錄。

User-agent: spider

Disallow: /a

對(duì)這樣的記錄機(jī)器人該怎么反應(yīng)?按照resseo技術(shù)教程教程標(biāo)準(zhǔn),機(jī)器人會(huì)將名為“a”的文件和名為“a”的目錄都disallow。當(dāng)然,黑帽seo技術(shù)易下拉試驗(yàn)比較符合邏輯切清晰的寫法是使用“/”來(lái)標(biāo)識(shí)所聲明的路徑:

Disallow: /a/

注意不要忘記“a”前面的“/”

根據(jù)“/”的意義,對(duì)于只允許某搜索引擎,有些robots.txt會(huì)這樣寫

User-agent: Baiduspider

Disallow:

User-agent: *

Disallow: /

這樣用百度的robots工具測(cè)試也是OK的,但從百度自家產(chǎn)品,百度知道的robots來(lái)看,更多的是寫成

User-agent: Baiduspider

Allow: ?/

User-agent: *

Disallow: /

我其實(shí)在想,或許“/”正確的表述應(yīng)該是"進(jìn)入該目錄"的意思,要不然Allow: ?/就不好理解了

在指示行末尾加注的問(wèn)題在“/robots.txt”文件中,凡以“#”開頭的行,均被視為注解內(nèi)容,這和unix中的慣例是一樣的。例如:

Disallow: /cgi-bin/ # this bans robots from our cgi-bin

盡量不要在一行的前面出現(xiàn)空格如“ disallow: /”《很多人非常不小心,空格就沒(méi)了》

Res標(biāo)準(zhǔn)并未對(duì)這種格式予以特別說(shuō)明,但和上面一個(gè)問(wèn)題一樣,可能導(dǎo)致某些機(jī)器人無(wú)法正確解讀。

文件目錄區(qū)分大小寫(這個(gè)或許是困惑大多數(shù)人的)雖然res標(biāo)準(zhǔn)忽略大小寫(case insensitive),但目錄和文件名卻是大小寫敏感的。所以對(duì)于”user-agent”和”disallow”指令,用大小寫都是可以的。但對(duì)于所聲明的目錄或文件名卻一定要注意大小寫的問(wèn)題。例如:

Disallow: /abc.htm

會(huì)攔截“http://www.example.com/abc.htm”

卻會(huì)允許http://www.example.com/Abc.htm

所以在IIS服務(wù)器可能出現(xiàn)的 諸多 大小寫目錄問(wèn)題,可以通過(guò)此方法得到圓滿解決。

如果頁(yè)面中包含了多個(gè)同類型meta標(biāo)簽,spider會(huì)累加內(nèi)容取值對(duì)于下面兩條語(yǔ)句來(lái)說(shuō):

搜索引擎將會(huì)理解成:

當(dāng)內(nèi)容取值沖突的時(shí)候,google和百度等大多數(shù)搜索引擎會(huì)采納限制性最強(qiáng)的參數(shù)例如,如果頁(yè)面中包含如下meta標(biāo)簽:

Spider會(huì)服從noindex的取值。

如果你既用了robots.txt文件又用了robots meta標(biāo)簽

當(dāng)二者出現(xiàn)沖突,googlebot會(huì)服從其中限制較嚴(yán)的規(guī)則

如果你在robots.txt中阻止了對(duì)一個(gè)頁(yè)面的檢索,googlebot永遠(yuǎn)不會(huì)爬到這個(gè)頁(yè)面,因此也根本不會(huì)讀到這個(gè)頁(yè)面上的meta標(biāo)簽。 如果你在robots.txt里面允許了對(duì)一個(gè)頁(yè)面的檢索,卻在meta標(biāo)簽中禁止了這一行為,googlebot會(huì)到達(dá)這個(gè)頁(yè)面,在讀到meta標(biāo)簽后終止進(jìn)一步的檢索行為。

當(dāng)然,前提是搜索引擎嚴(yán)格按照robots來(lái)辦事

劉總說(shuō)的robots很詳細(xì),另外還有大神補(bǔ)充一個(gè)經(jīng)常出現(xiàn)的問(wèn)題,就是robots.txt本身文件的格式是utf-8的,用一些文本編輯器在生成的時(shí)候,經(jīng)常會(huì)出現(xiàn)在文本前出現(xiàn)多處的ascii碼問(wèn)題,這樣的情況就造成了User-agent:讀取出錯(cuò)。

可以在 google 站長(zhǎng)工具 或?http://tool.motoricerca.info/robots-checker.phtml?進(jìn)行檢測(cè)。

以上是潮人地東莞seo博客跟大家分享關(guān)于seo技術(shù)博客分享:你真的完全懂了robots嗎?等問(wèn)題,希望能對(duì)大家有所幫助,若有不足之處,請(qǐng)諒解,我們大家可以一起討論關(guān)于網(wǎng)站seo優(yōu)化排名的技巧,一起學(xué)習(xí),以上內(nèi)容僅供參考。